노출 늘리기 (크롤러 가이드)

데이블 네트워크의 일부 게재지면은 웹정보 수집을 위한 크롤러에 대한 가이드를 필수적으로 요구합니다. 아래에서 robots.txt 파일을 생성하는 방법을 확인하세요.

1. 메모장을 켜주세요.

•

메모장과 같이 컴퓨터에 기본으로 내장되어 있는 텍스트 편집기를 켜주십시오.

•

메모장 안에 아래의 구문을 그대로 복사한 뒤 붙여넣기 해주십시오.

User-agent: AdsBot-Google-Mobile

User-agent: AdsBot-Google

User-agent: Googlebot

Allow: /

Plain Text

복사

→ 데스크톱 수집을 위한 구글 봇, 모바일 수집을 위한 구글 봇, 구글 검색봇의 수집을 허용하겠다는 의미입니다.

2. 파일을 저장하고 업로드 해주세요.

•

Robots.txt 파일을 생성했다면 ‘저장’을 해주세요. 파일 이름은 꼭 robots.txt로 지정하셔야 합니다.

•

Robots.txt 파일을 서버의 최상위 디렉토리(=사이트 루트)에 업로드 해주십시오. (최상위 디렉토리란, 폴더를 예로 들면 ‘최상위 폴더’ 입니다.)Q. ‘데이블’이란 최상위 폴더 안에 A고객사, B고객사, C고객사의 폴더가 있을 때, 사이트 루트는 무엇일까요?A. 정답은 바로 ‘데이블’입니다.

•

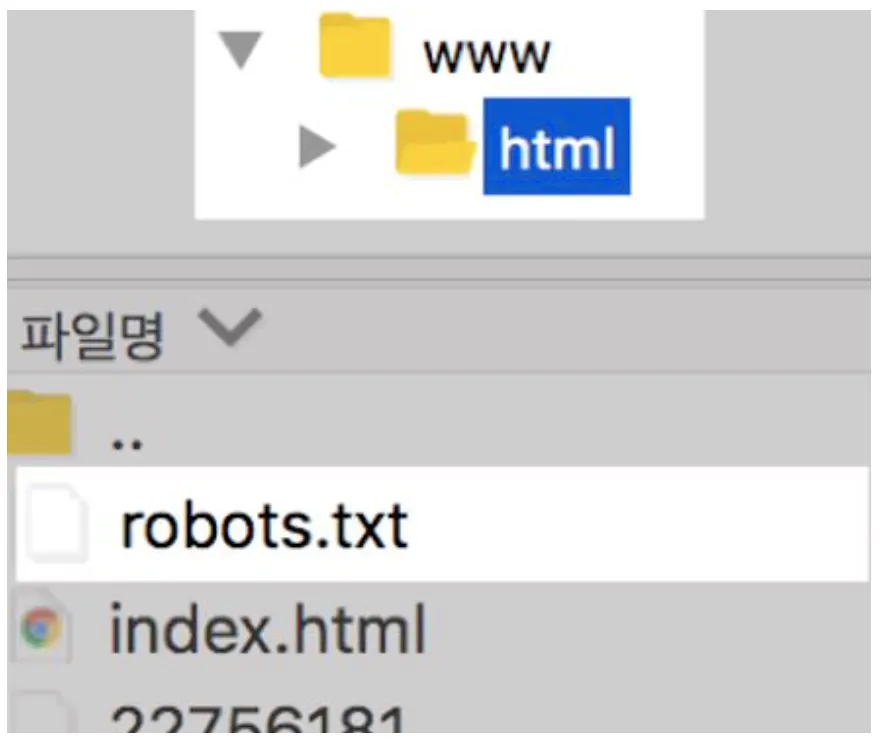

최상위 디렉토리는 보통 public_html, html, www, wwwroot, htdocs라는 이름을 가집니다.만약 public_html, html, www, wwwroot, htdocs라는 이름을 가진 폴더가 없다면, 인덱스 파일(index.php, index.html, default.html)이 있는 폴더를 찾아주십시오. 그 폴더 robots.txt 파일을 업로드하시면 완료입니다.(www 안의 html 폴더일 수도 있습니다.)

3. 제대로 파일이 생성되었는지 확인 해보십시오.

•

예를 들어 웹사이트 주소가 www.dable.io라면, www.dable.io/robots.txt를 주소창에 입력했을 때 메모장에 입력한 내용이 그대로 뜬다면, 정상적으로 robots.txt 파일이 업로드 된 것입니다.

•

•

사이트에는 robots.txt 파일이 하나만 존재해야 합니다.

카페 24 가이드

이 링크를 참고하셔서 PC 및 모바일 쇼핑몰 탭에 아래의 구문을 그대로 복사한 뒤 붙여넣기 해주십시오.

User-agent: AdsBot-Google-Mobile

User-agent: AdsBot-Google

User-agent: Googlebot

Allow: /

Plain Text

복사

파일 생성 및 업로드가 완료됩니다.

네이버 & 다음 가이드

네이버는 로봇명은 Yeti, 다음의 로봇명은 Daumoa 입니다.

만약 네이버와 다음의 크롤링도 허용하고 싶다면 아래처럼 robots.txt 파일을 만들어 주십시오.

네이버

User-agent: Yeti

Allow: /

Plain Text

복사

다음

User-agent: Daumoa

Allow: /

Plain Text

복사